Zawartość dodana przez adek

-

AI i technologie przyszłości

@Nezumi zerknij na przykład na to: Ale efekty sprawdź na stronie projektu.

-

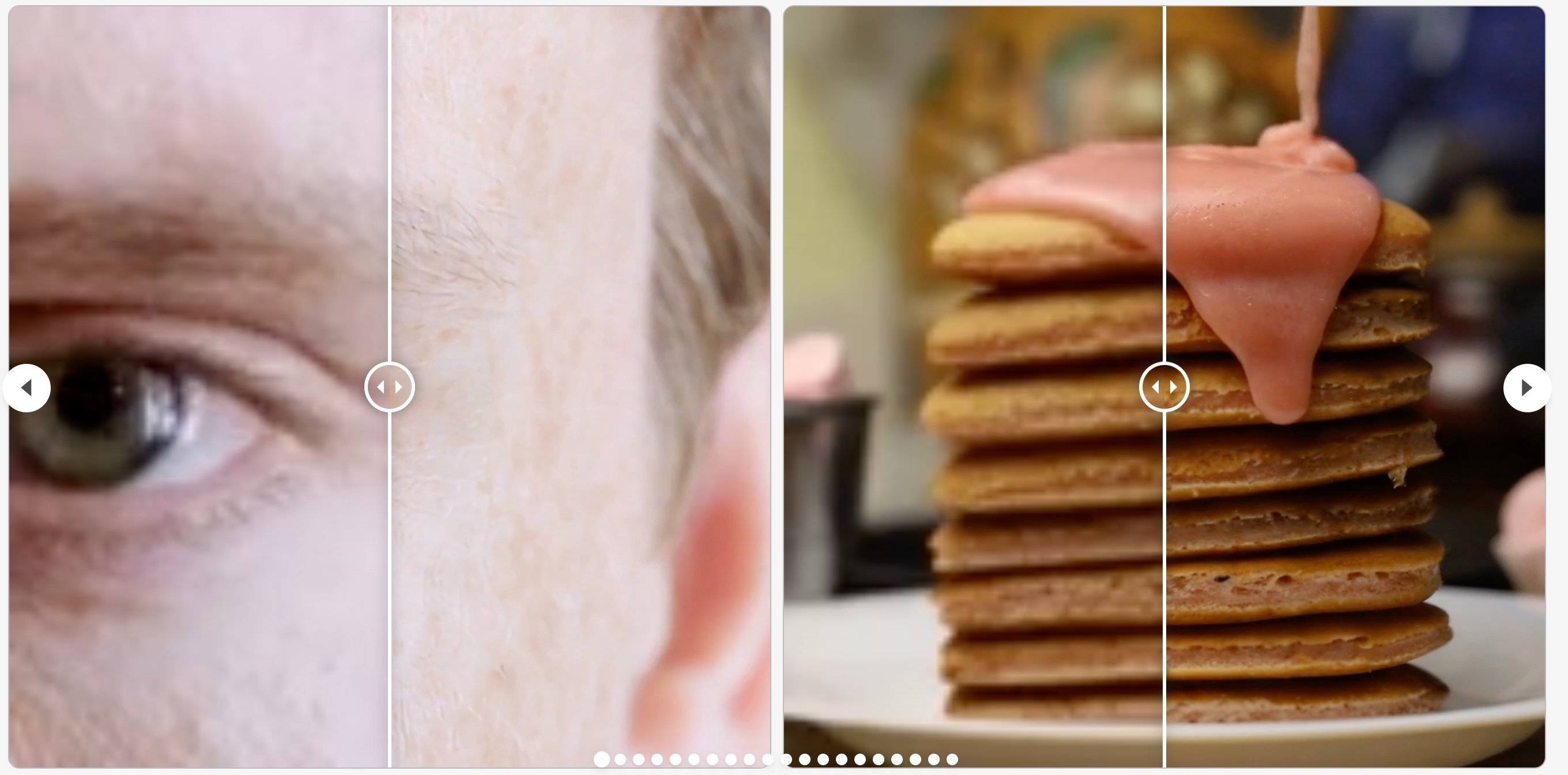

VideoGigaGAN - technologia super-rozdzielczości wideo od Adobe Research

VideoGigaGAN to projekt naukowców University of Maryland, College Park oraz Adobe Research. Przyznam szczerze, że to jeden z projektów, który zrobił na mnie największe wrażenie w ostatnich miesiącach. Czym jest VideoGigaGAN? W skrócie jest to technologia pozwalająca na poprawę jakości wideo. Ale no właśnie, w jaki sposób. Tutaj posłużę się tym co zostało zamieszczone na stronie projektu: Brzmi skomplikowanie, ale zachęcam jednak do rzucenia okiem na stronę projektu. Znajdziecie tam świetną dokumentację i masę przykładów, której pokazują efekty tych algorytmów. Strona projektu: https://videogigagan.github.io/ Nie wiadomo jeszcze kiedy będziemy mogli korzystać z tych algorytmów, ale biorąc pod uwagę, że konferencja Adobe MAX odbędzie się w ciągu kilku godzin od pisania tego tekstu - kto wie, być może właśnie jutro dowiemy się czy VideoGigaGAN zostanie dodany do któregoś z produktów z pakietu Adobe Cloud. Zobacz cały news

-

VideoGigaGAN - technologia super-rozdzielczości wideo od Adobe Research

VideoGigaGAN to projekt naukowców University of Maryland, College Park oraz Adobe Research. Przyznam szczerze, że to jeden z projektów, który zrobił na mnie największe wrażenie w ostatnich miesiącach. Czym jest VideoGigaGAN? W skrócie jest to technologia pozwalająca na poprawę jakości wideo. Ale no właśnie, w jaki sposób. Tutaj posłużę się tym co zostało zamieszczone na stronie projektu: Brzmi skomplikowanie, ale zachęcam jednak do rzucenia okiem na stronę projektu. Znajdziecie tam świetną dokumentację i masę przykładów, której pokazują efekty tych algorytmów. Strona projektu: https://videogigagan.github.io/ Nie wiadomo jeszcze kiedy będziemy mogli korzystać z tych algorytmów, ale biorąc pod uwagę, że konferencja Adobe MAX odbędzie się w ciągu kilku godzin od pisania tego tekstu - kto wie, być może właśnie jutro dowiemy się czy VideoGigaGAN zostanie dodany do któregoś z produktów z pakietu Adobe Cloud.

-

AI i technologie przyszłości

No ja słyszalem co innego, ale zobaczymy. Może też w mocno ograniczonej formie. Jeśli to byłaby ta forma, którą pokazywali to subskrypcja będzie ultra droga. W momencie gdy brakuje GPU na świecie do przeliczania tych ich innych modeli podobno to nie jest jakiś super priorytet. Ale to się zmienia co chwilę.

-

AI i technologie przyszłości

Rewolucja to modele językowe i możliwość wydawania poleceń właśnie w języku naturalnym. Tutaj rewolucja odbywa się np. programowaniu. Możesz tworzyć programy, którym polecenia możesz podawać w sposób naturalny i tutaj uruchamiać konkretne akcje. Nic tak w historii jeszcze nie przyspieszyło automatyzacji jak właśnie te modele. W tym sensie mi chodziło, że to nie sam generator obrazków czy chat gpt. Samo GPT jest już rewolucją. Dzisiaj naprawdę ciężko bez niego pracować w projektach programistycznych. I nie, nie piszą ad A do Z za ciebie wszystkiego. Natomiast prowadzą za rękę, przyspieszą pracę x10. Co do grafiki - cały szereg algorytmów przetwarzających obrazy (których trochę efektem ubocznym są te generatory obrazów). Ale same algorytmy upscalingu, edycji w locie. Jeśli chodzi o SORĘ - też źle chyba zostałem zrozumiany. Owszem, to jest rewolucja, ale to nie jest jeszcze coś co może zostać oddane jako produkt dla ludzi. Po prostu koszt generowania tych filmów dzisiaj jest ogromny i tyle. Machine Learning - owszem, to jest coś co było od lat. Ale lata temu nie mogliśmy nauczyć modeli większości tych tych rzeczy. Myślę, że każdy tutaj może mieć inny punkt odniesienia i OK. To co daje Adobe czy niektóre popularne programy to faktycznie są "zabawki" (chociaż w Photoshopie widziałem całkiem niezłe efekty tych zabawek). Jak znajdę chwilę to opiszę w newsie nowy model Adobe Research właśnie do upscalingu wideo, który jest wg mnie dużym wow (chyba, że jutro go na konferencji przedstawią). Ja mam wrażenie, że w programach typu Adobe Photoshop, telefonach - widzimy faktycznie pewne wodotryski - użyteczne, ale nie są to rzeczy, które zmieniają jakoś życie. Natomiast w IT - na poziomie tworzenia i pracy z modelami LLM. Uważam, że to jest rewolucja.

-

AI i technologie przyszłości

@Nezumi No trochę z tym, że AI stoi w miejscu to pojechałeś. Nie stoi, i to bardzo nie stoi. Nie patrz na AI pod kątem kolejnego generatora obrazków czy Chata GPT. AI to nie tylko chat gpt.

-

Max3D 2020 - Komentarze i uwagi

Kolejne zmiany. Robi się czyściej. Usuwam niepotrzebne rzeczy jak i reklamy. Trudno. Mam pewien plan na monetyzacje bez reklam, ale na to przyjdzie czas jak uda się to zrobić. Docelowo jeśli to wypali to całkowicie reklamy znikną myślę.

-

AI i technologie przyszłości

Mały update odnośnie SORA. Raczej małe są szanse, że my ją zobaczymy. Na ten moment - generowanie tych próbek, który były pokazywane jest olbrzymim obciążeniem obliczeniowym. Średnio dzisiaj nadaje się to na produkt dla użytkowników taki jak Chat GPT4. W momencie gdyby SORA została udostępniona - będzie to wtedy ultra drogi produkt. Natomiast właśnie, nigdy nie wiecie też czy z efektu działania będziecie zadowoleni.

-

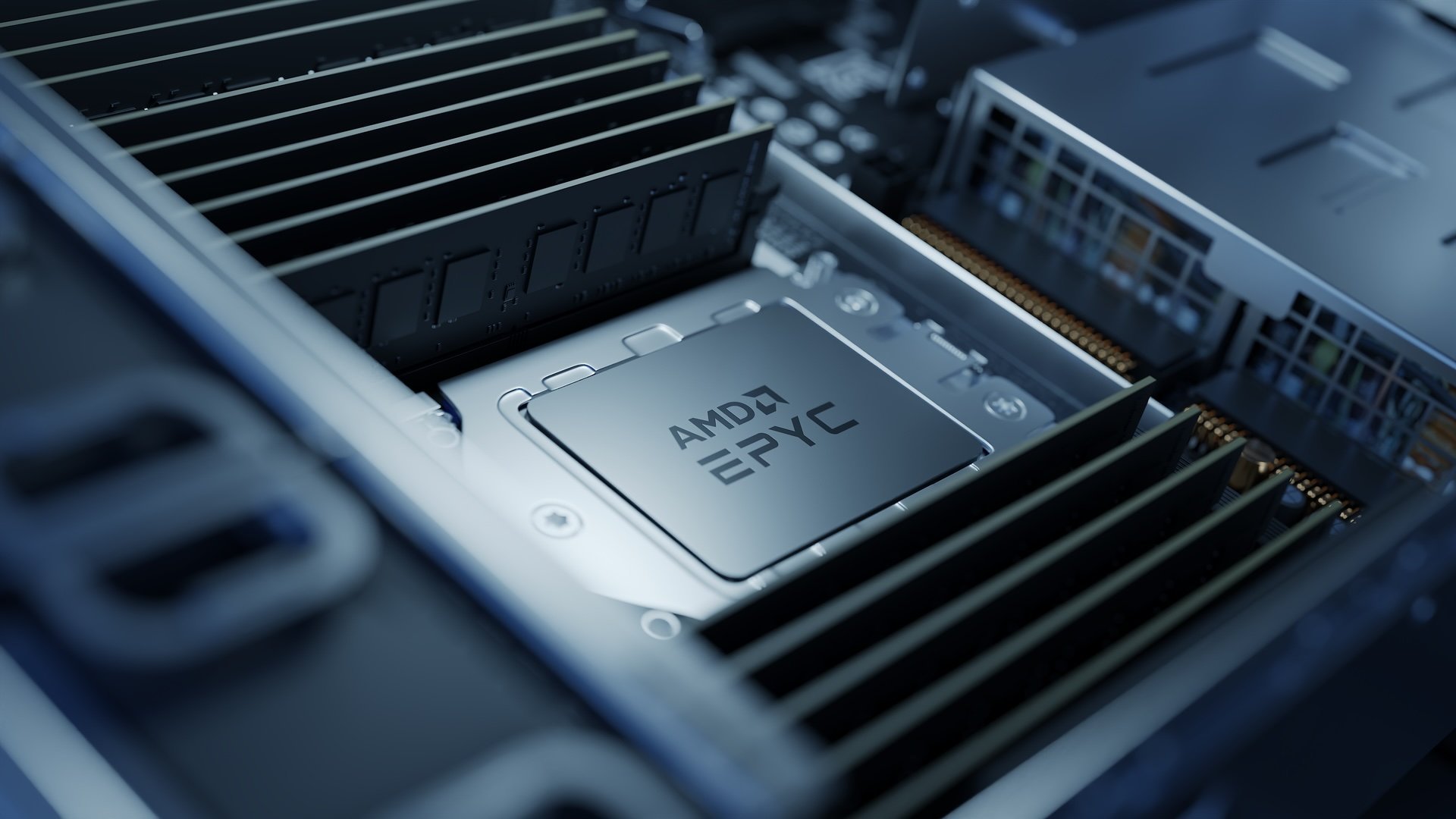

Platige Image pogłębia współpracę sprzętową z AMD

W 2017 roku, czyli krótko po premierze pierwszej generacji procesorów AMD Ryzen Threadripper, Platige Image zakupiła kilkadziesiąt maszyn napędzanych przez te przełomowe wówczas układy. Komputery szybko stały się wymarzoną platformą dla części zadań realizowanych przez farmę obliczeniową, a także pod biurkami artystów, którzy dzięki temu mogli pracować znacznie bardziej efektywnie. Współpraca z AMD otworzyła nowy rozdział rozwoju systemów obliczeniowych firmy, dodatkowo przyspieszając, gdy zainwestowano w systemy z nowymi generacjami procesorów z rodziny Threadripper, a następnie w 2020 roku, gdy pojawiły się pierwsze serwery z AMD EPYC. Moc obliczeniowa jest w Platige Image o tyle istotna, że jedną z kluczowych składowych procesu tworzenia grafiki jest rendering. W zależności od stopnia skomplikowania sceny, rozdzielczości, zadanych parametrów pojedyncza klatka może się renderować od kilku minut do nawet kilkunastu godzin. Każda sekunda materiału może mieć takich klatek od 24 do 60, a nawet więcej w przypadku niektórych projektów. Proces renderingu jest też procesem iteracyjnym, czyli każda klatka może wymagać nawet kilkudziesięciu przeliczeń, aby efekt był najwyższej jakości. Platige Image dysponuje własnym centrum danych, które od 2020 roku zaczęło modernizować o maszyny napędzane procesorami AMD EPYC. Maszyny te zajmują się przede wszystkim procesem renderingu, ale również wykorzystywane są jako serwery usług, centra danych czy do wirtualizacji. Obecnie większość mocy obliczeniowej jakim dysponuje centrum danych opiera się na 64 rdzeniowych układach AMD EPYC 7H12 oraz AMD EPYC 7763. Zdecydowano się zatem na modele o największej gęstości rdzeni, jaka była dostępna, uzyskując maszyny o niezwykłym wówczas stosunku mocy do zajmowanej przestrzeni. Wydajność zastosowanych procesorów przełożyła się też na oszczędności w zakresie licencjonowania oprogramowania, z którego korzysta Platige Image w procesie renderingu. „Zastosowanie procesorów z rodziny EPYC pozwoliło nam zwiększyć jednostkową wydajność obliczeniową względem dotychczas stosowanych platform od 50% (wzgl. poprzedniej generacji) do ok. 120% (względem najstarszej aktualnie używanej generacji) przy zachowaniu porównywalnego poboru prądu. Warto także wspomnieć jak istotną kwestią w zakresie rozbudowy czy utrzymania centrum danych jest optymalizacja kosztowa i energetyczna. Platforma EPYC świetnie wpisuje się te wymagania.” – powiedział Tomasz Kruszona, dyrektor ds. technologii w Platige Image. Platige Image to jedno z najbardziej rozpoznawalnych na świecie polskich studiów produkcyjnych. Spółka specjalizuje się w grafice komputerowej, animacji 3D i ma na swoim koncie współpracę z najbardziej znaczącymi wydawcami gier. Platige jest szczególnie cenione za animacje graficzne tworzone dla nawet najbardziej znanych twórców gier wideo. Jest to więc firma, której wizja rozwoju nie ustępuje niesamowitym projektom artystycznym, a stosowana przez nią technologia ma niebagatelne znaczenie w osiąganiu coraz bardziej imponujących efektów, które są wyznacznikiem w branży. Dzięki swoim inwestycjom i pogłębiającej się współpracy z AMD to polskie studio jest dziś znakomicie przygotowane na to, co przyniesie przyszłość. [źródło: Material prasowy AMD] Zobacz cały news

-

Platige Image pogłębia współpracę sprzętową z AMD

W 2017 roku, czyli krótko po premierze pierwszej generacji procesorów AMD Ryzen Threadripper, Platige Image zakupiła kilkadziesiąt maszyn napędzanych przez te przełomowe wówczas układy. Komputery szybko stały się wymarzoną platformą dla części zadań realizowanych przez farmę obliczeniową, a także pod biurkami artystów, którzy dzięki temu mogli pracować znacznie bardziej efektywnie. Współpraca z AMD otworzyła nowy rozdział rozwoju systemów obliczeniowych firmy, dodatkowo przyspieszając, gdy zainwestowano w systemy z nowymi generacjami procesorów z rodziny Threadripper, a następnie w 2020 roku, gdy pojawiły się pierwsze serwery z AMD EPYC. Moc obliczeniowa jest w Platige Image o tyle istotna, że jedną z kluczowych składowych procesu tworzenia grafiki jest rendering. W zależności od stopnia skomplikowania sceny, rozdzielczości, zadanych parametrów pojedyncza klatka może się renderować od kilku minut do nawet kilkunastu godzin. Każda sekunda materiału może mieć takich klatek od 24 do 60, a nawet więcej w przypadku niektórych projektów. Proces renderingu jest też procesem iteracyjnym, czyli każda klatka może wymagać nawet kilkudziesięciu przeliczeń, aby efekt był najwyższej jakości. Platige Image dysponuje własnym centrum danych, które od 2020 roku zaczęło modernizować o maszyny napędzane procesorami AMD EPYC. Maszyny te zajmują się przede wszystkim procesem renderingu, ale również wykorzystywane są jako serwery usług, centra danych czy do wirtualizacji. Obecnie większość mocy obliczeniowej jakim dysponuje centrum danych opiera się na 64 rdzeniowych układach AMD EPYC 7H12 oraz AMD EPYC 7763. Zdecydowano się zatem na modele o największej gęstości rdzeni, jaka była dostępna, uzyskując maszyny o niezwykłym wówczas stosunku mocy do zajmowanej przestrzeni. Wydajność zastosowanych procesorów przełożyła się też na oszczędności w zakresie licencjonowania oprogramowania, z którego korzysta Platige Image w procesie renderingu. „Zastosowanie procesorów z rodziny EPYC pozwoliło nam zwiększyć jednostkową wydajność obliczeniową względem dotychczas stosowanych platform od 50% (wzgl. poprzedniej generacji) do ok. 120% (względem najstarszej aktualnie używanej generacji) przy zachowaniu porównywalnego poboru prądu. Warto także wspomnieć jak istotną kwestią w zakresie rozbudowy czy utrzymania centrum danych jest optymalizacja kosztowa i energetyczna. Platforma EPYC świetnie wpisuje się te wymagania.” – powiedział Tomasz Kruszona, dyrektor ds. technologii w Platige Image. Platige Image to jedno z najbardziej rozpoznawalnych na świecie polskich studiów produkcyjnych. Spółka specjalizuje się w grafice komputerowej, animacji 3D i ma na swoim koncie współpracę z najbardziej znaczącymi wydawcami gier. Platige jest szczególnie cenione za animacje graficzne tworzone dla nawet najbardziej znanych twórców gier wideo. Jest to więc firma, której wizja rozwoju nie ustępuje niesamowitym projektom artystycznym, a stosowana przez nią technologia ma niebagatelne znaczenie w osiąganiu coraz bardziej imponujących efektów, które są wyznacznikiem w branży. Dzięki swoim inwestycjom i pogłębiającej się współpracy z AMD to polskie studio jest dziś znakomicie przygotowane na to, co przyniesie przyszłość. [źródło: Material prasowy AMD]

-

Generatywne AI wkracza do Adobe Premiere Pro

Pamiętaj, że dzisiaj wideo stoi głównie internetem i do shortsów, tiktoków, reelsów pewnie to wystarczy.

-

Generatywne AI wkracza do Adobe Premiere Pro

Adobe ogłosiło wprowadzenie kilku technologii generatywnego AI, które zostaną zintegrowane z Adobe Premiere Pro. Inicjatywa ta jest częścią szerszej strategii Adobe, mającej na celu wdrażanie AI w usługach Creative Cloud, co ma zwiększyć produktywność i możliwości kreatywne profesjonalistów. Wśród kluczowych rozwojów znajduje się wprowadzenie modelu wideo Adobe Firefly, rozszerzającego już dostępną gamę modeli AI, takich jak Firefly Image i Text Effects. Dodatkowo, Adobe bada możliwości partnerstwa z dostawcami AI stron trzecich, takimi jak Sora od OpenAI, RunwayML i Pika, aby rozszerzyć gamę narzędzi dostępnych w Premiere Pro. Wśród nowych narzędzi zaprezentowano Generative Extend, które umożliwia montażystom dodawanie klatek na początku lub na końcu klipu w celu doprecyzowania montażu lub przedłużenia scen. Narzędzia do dodawania i usuwania obiektów umożliwiają precyzyjną edycję poruszających się obiektów w scenie, zwiększając zdolności montażysty do manipulacji i poprawy narracji wizualnej. Na koniec, funkcja Generative B-Roll oferuje montażystom możliwość generowania klipów wideo z tekstowych poleceń. Adobe zobowiązało się do zachowania przejrzystości w stosowaniu AI poprzez inicjatywy takie jak Content Credentials, które informują użytkowników o modelach AI używanych w tworzeniu mediów. Oficjalny wpis na blogu Adobe: https://blog.adobe.com/en/publish/2024/04/15/bringing-gen-ai-to-video-editing-workflows-adobe-premiere-pro Zobacz cały news

-

Generatywne AI wkracza do Adobe Premiere Pro

Adobe ogłosiło wprowadzenie kilku technologii generatywnego AI, które zostaną zintegrowane z Adobe Premiere Pro. Inicjatywa ta jest częścią szerszej strategii Adobe, mającej na celu wdrażanie AI w usługach Creative Cloud, co ma zwiększyć produktywność i możliwości kreatywne profesjonalistów. Wśród kluczowych rozwojów znajduje się wprowadzenie modelu wideo Adobe Firefly, rozszerzającego już dostępną gamę modeli AI, takich jak Firefly Image i Text Effects. Dodatkowo, Adobe bada możliwości partnerstwa z dostawcami AI stron trzecich, takimi jak Sora od OpenAI, RunwayML i Pika, aby rozszerzyć gamę narzędzi dostępnych w Premiere Pro. Wśród nowych narzędzi zaprezentowano Generative Extend, które umożliwia montażystom dodawanie klatek na początku lub na końcu klipu w celu doprecyzowania montażu lub przedłużenia scen. Narzędzia do dodawania i usuwania obiektów umożliwiają precyzyjną edycję poruszających się obiektów w scenie, zwiększając zdolności montażysty do manipulacji i poprawy narracji wizualnej. Na koniec, funkcja Generative B-Roll oferuje montażystom możliwość generowania klipów wideo z tekstowych poleceń. Adobe zobowiązało się do zachowania przejrzystości w stosowaniu AI poprzez inicjatywy takie jak Content Credentials, które informują użytkowników o modelach AI używanych w tworzeniu mediów. Oficjalny wpis na blogu Adobe: https://blog.adobe.com/en/publish/2024/04/15/bringing-gen-ai-to-video-editing-workflows-adobe-premiere-pro

-

Max3D 2020 - Komentarze i uwagi

Będę pewnie z tym walczył, ale to oficjalny wydajniejszy widget do tego. Tamten mocno spowalniał. Tutaj mi się podoba liczba postów w wątku, ale będę chciał to trochę nadpisać i usunąć emotki itp.

-

Max3D 2020 - Komentarze i uwagi

Informacyjnie. Porządkując trochę usunąłem większość reklam (tych wyskakujących, bocznych).

-

BuildingGen: rewolucja w tworzeniu budynków 3d

Reallusion wprowadziło na rynek BuildingGen, nowe narzędzie ułatwiające projektowanie budynków 3D. Wyróżnia się ono na tle innych generatorów modułowych budynków tym, że zamiast skomplikowanej edycji "nodami" oferuje elastyczne schematy (Blueprints). Użytkownicy wprowadzają podstawowe jednostki, określają liczbę pięter i układają komponenty, aby skonstruować budynek. Narzędzie to umożliwia także modyfikacje w czasie rzeczywistym oraz podgląd projektu podczas pracy. Podstawowy pakiet zawiera bibliotekę ponad 210 próbek i komponentów, w tym 10 zaprojektowanych budynków i liczne materiały. Dla użytkowników, którzy chcą spersonalizować budynki, dostępne są narzędzia umożliwiające modyfikację lub tworzenie nowych stylów. Użytkownicy mogą dostosowywać struktury budynków, dodając lub usuwając elementy takie jak filary czy ogrodzenia, oraz ulepszać zewnętrzne wykończenia, zmieniając materiały i dekoracyjne składniki. Dostępne są również dodatkowe płatne pakiety rozszerzeń. Oprogramowanie to zawiera również funkcję optymalizacji, która poprawia wydajność poprzez konsolidację tekstur i modeli. BuildingGen oferuje także funkcję jednoklikowego przełączania między dniem a nocą, dodając dynamiczne efekty świetlne. BuildingGen posiada narzędzia do pakowania, które umożliwiają użytkownikom integrację zewnętrznej zawartości oraz dostosowanie pakietów budynków do określonych stylów lub epok. Ułatwia to architektom i projektantom zachowanie spójności w różnych projektach. Więcej informacji: https://www.reallusion.com/iclone/building-gen/ Zobacz cały news

-

BuildingGen: rewolucja w tworzeniu budynków 3d

Reallusion wprowadziło na rynek BuildingGen, nowe narzędzie ułatwiające projektowanie budynków 3D. Wyróżnia się ono na tle innych generatorów modułowych budynków tym, że zamiast skomplikowanej edycji "nodami" oferuje elastyczne schematy (Blueprints). Użytkownicy wprowadzają podstawowe jednostki, określają liczbę pięter i układają komponenty, aby skonstruować budynek. Narzędzie to umożliwia także modyfikacje w czasie rzeczywistym oraz podgląd projektu podczas pracy. Podstawowy pakiet zawiera bibliotekę ponad 210 próbek i komponentów, w tym 10 zaprojektowanych budynków i liczne materiały. Dla użytkowników, którzy chcą spersonalizować budynki, dostępne są narzędzia umożliwiające modyfikację lub tworzenie nowych stylów. Użytkownicy mogą dostosowywać struktury budynków, dodając lub usuwając elementy takie jak filary czy ogrodzenia, oraz ulepszać zewnętrzne wykończenia, zmieniając materiały i dekoracyjne składniki. Dostępne są również dodatkowe płatne pakiety rozszerzeń. Oprogramowanie to zawiera również funkcję optymalizacji, która poprawia wydajność poprzez konsolidację tekstur i modeli. BuildingGen oferuje także funkcję jednoklikowego przełączania między dniem a nocą, dodając dynamiczne efekty świetlne. BuildingGen posiada narzędzia do pakowania, które umożliwiają użytkownikom integrację zewnętrznej zawartości oraz dostosowanie pakietów budynków do określonych stylów lub epok. Ułatwia to architektom i projektantom zachowanie spójności w różnych projektach. Więcej informacji: https://www.reallusion.com/iclone/building-gen/

-

AI stworzyło zwycięski Teledysk w Konkursie Pink Floyd

@RaVirr hmm.. jego strona już nie działa. A YT chyba tutaj: https://www.youtube.com/@danielzagorski/videos

-

AI stworzyło zwycięski Teledysk w Konkursie Pink Floyd

@kengi ta playlista była wrzucona do newsa. Po kliknięciu masz wszystko. Ale YT to tak dziwnie osadza. @RaVirr Dziadek3D - tak. Aczkolwiek Dziadek sprzed kilku lat. Jak srprawdzicie nowsze filmy Dziadka to naprawdę ciekawie sobie działa. Co do filmu - cholera. Co innego jakby to było użyte do podciągnięcia czegoś, nie wiem, a nie zlepek kilkusekundowych generacji.

-

AI stworzyło zwycięski Teledysk w Konkursie Pink Floyd

Kliknąłeś w to co wkleiłem? Wejdź też na playlistę. Nie było źle.

-

AI stworzyło zwycięski Teledysk w Konkursie Pink Floyd

W ramach obchodów 50-lecia wydania kultowego albumu "The Dark Side of The Moon" przez Pink Floyd, zorganizowany został unikatowy konkurs. Jego uczestnicy mieli za zadanie stworzyć teledysk do jednej z piosenek z albumu. Po wielu miesiącach kreatywnych prac, ogłoszono wyniki na platformie społecznościowej X. Zwycięzcą okazało się wideo, które zostało wygenerowane przez sztuczną inteligencję, co wywołało mieszane reakcje wśród fanów i twórców. W konkursie uczestniczyło wiele znakomitych prac, w tym ręcznie animowane filmy, jednak to AI zdobyło najwyższe uznanie. To wydarzenie rodzi pytania o przyszłość twórczości artystycznej i rosnącą rolę technologii w sztuce. Czy jesteśmy już gotowi, aby zaakceptować dominację AI w takich dziedzinach jak film czy muzyka? Film, który wygrał: Inny przykład filmu zgłoszonego do konkursu (trzeba kliknąć i przejść do YT ze względu na ograniczenia wiekowe): Pełna lista filmów znajduje się pod tym adresem: Zobacz cały news

-

AI stworzyło zwycięski Teledysk w Konkursie Pink Floyd

W ramach obchodów 50-lecia wydania kultowego albumu "The Dark Side of The Moon" przez Pink Floyd, zorganizowany został unikatowy konkurs. Jego uczestnicy mieli za zadanie stworzyć teledysk do jednej z piosenek z albumu. Po wielu miesiącach kreatywnych prac, ogłoszono wyniki na platformie społecznościowej X. Zwycięzcą okazało się wideo, które zostało wygenerowane przez sztuczną inteligencję, co wywołało mieszane reakcje wśród fanów i twórców. W konkursie uczestniczyło wiele znakomitych prac, w tym ręcznie animowane filmy, jednak to AI zdobyło najwyższe uznanie. To wydarzenie rodzi pytania o przyszłość twórczości artystycznej i rosnącą rolę technologii w sztuce. Czy jesteśmy już gotowi, aby zaakceptować dominację AI w takich dziedzinach jak film czy muzyka? Film, który wygrał: Inny przykład filmu zgłoszonego do konkursu (trzeba kliknąć i przejść do YT ze względu na ograniczenia wiekowe): Pełna lista filmów znajduje się pod tym adresem:

-

Revrite

Przepiękne. Po powiększeniu te detale. Dobra, wrzucaj więcej tych prac 🙂

-

[WIP] Nepentes

Rewelacja. Ale mi się to podoba stylistycznie. Animacje również świetne. TIP: Zdaje się, że Youtube osadza się automatycznie tylko musisz wkleić link do filmu (pełny, nie ten skrócony).

-

Rozwój kompetencji i uczelnie w Polsce

Miałem podobne przemyślenia - głównie dlatego, że osoba zainteresowana nie jest jakoś aktywna w wątku (nawet reakcjami). Baa... przez chwilę myślałem, że to coś wygenerowanego GPT4 - ale nie ma tutaj żadnych sugestii ani linków. Podobają mi się odpowiedzi - był kiedyś taki wątek, ale wersja 2024 się przyda. Nie zmienia to faktu, że dyskusja rzeczowa.